12月14日下午,“统计大讲堂”系列讲座第178讲举行。本次讲座采取线上会议的方式,邀请中国人民大学统计学院讲师Jeffrey Chu作题为“关于减少大数据集大小估计量的偏差”的报告。讲座由中国人民大学统计学院副教授孙怡帆主持。

孙怡帆介绍了主讲人的相关信息。Jeffrey Chu是中国人民大学统计学院数理统计系讲师,同时也是英国曼彻斯特大学数学学院博士,曾先后在英国曼彻斯特大学,马德里卡洛斯三世大学作为博士后和讲师承担教学、科研工作。研究方向围绕统计分布理论,统计学在区块链和加密货币的应用。研究论文发表于Journal of Computational and Applied Mathematics,Computational Statistics & Data Analysis等国际高水平期刊上。主持并参与了沙迦美国大学智慧城市研究项目等多个课题。

Jeffrey首先对大数据集进行了基本介绍。大数据集是数据的集合,通常可以用图表呈现,经过计算分析可以用于揭示某个方面相关的模式和趋势,如何用大数据集给出最准确的估计结果是值得研究的问题。但在许多情况下,人力是有限的,手工处理大数据集很耗时。此外,访问全部数据也可能受到时间和成本等因素的限制。作为对现有方法的扩展,Jeffrey提出了四种新的大数据集大小估计方法,并与大数据文献中的两种现有方法在偏差方面进行了比较,随后他对这四种估计方法作了深入的介绍。

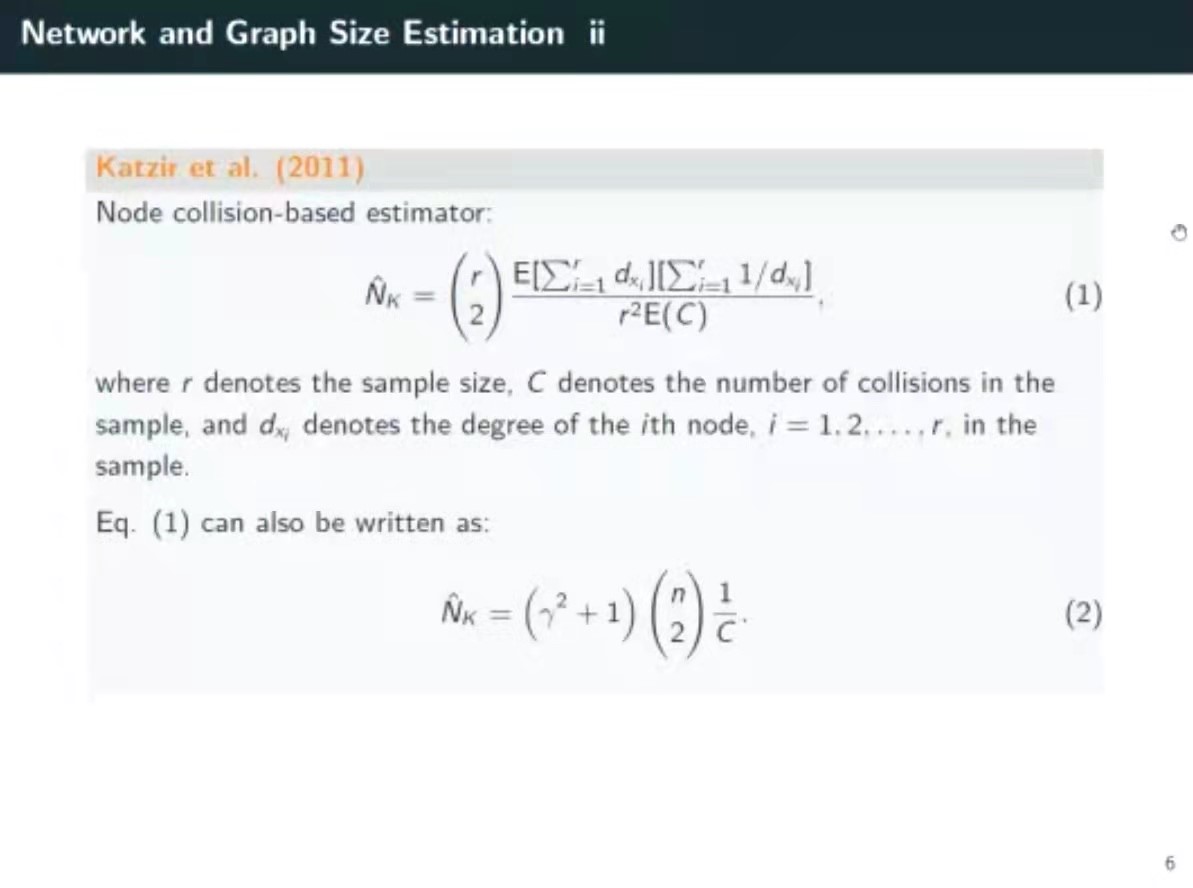

他指出,对大数据集大小估计的研究并不是一个全新的领域,早在1900年就有对其估计量的偏差的相关研究,大多数的方法都是基于样本间的碰撞。无论大数据集中样本大小如何,有关样本的图表越多,人们对于偏差的感知就越强烈。

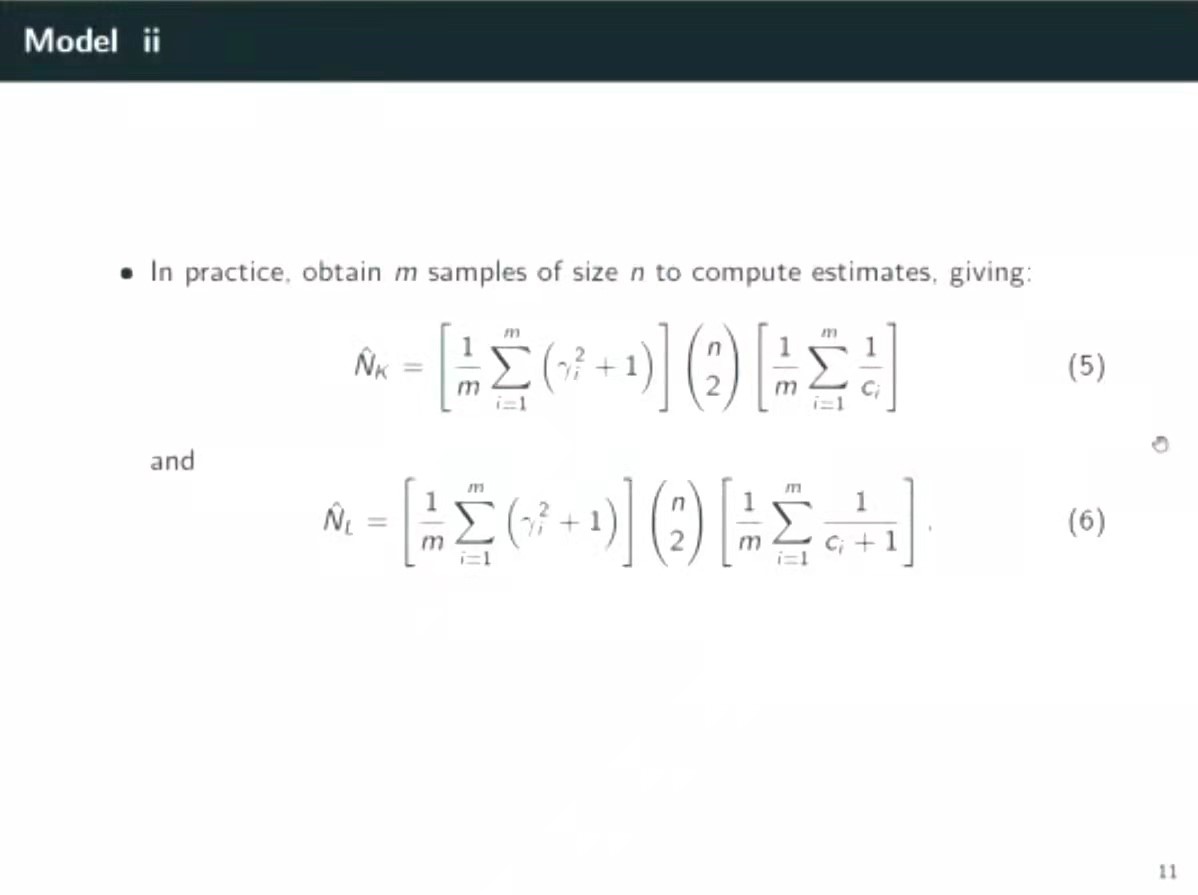

为了加深同学们的理解,Jeffrey列举了一个模型。假设大数据集可以用无向图来表现,在这样的背景下,可以通过无向图的重叠部分,得到模拟样本点。该种方法下,能够得到一个服从二项分布的随机变量,但是这个变量是存在问题的,它依赖于真实的数据集大小。为了解决这个问题,Jeffrey建议使用最小预期损失估计法。

Jeffrey进行了对比研究,进一步说明了他提出的大数据集大小估计法在减小偏差问题上的优越性。对比一方面基于模拟研究,一方面基于这些方法对五个真实网络数据集(Twitter, LiveJournal, Pokec, Youtube, Wikipedia Talk)的具体应用。结果明显表明,优化后的方法虽然不能产生最准确的总体估计量,但在大数据集样本量较小时,偏差相对较小,估计量已经能很好地符合预期。

最后,在提问交流环节,在线师生积极参与讨论,Jeffrey耐心解答了同学们的疑问,并和同学们一起就大数据集大小估计方法做了更加深入的探讨。

此后“统计大讲堂”系列将陆续推出更多精彩讲座,敬请关注。